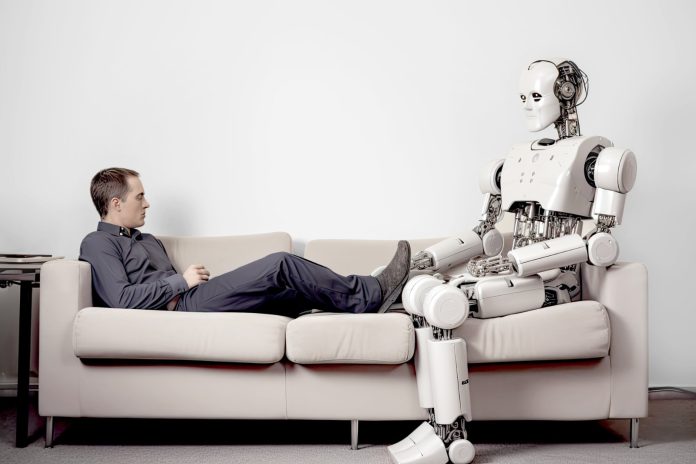

Yapay zekâ ile sohbet etmek artık sadece bilgi almak için yapılan bir eylem değil; milyonlarca kişi, terapi arayışında bir insan yerine bir algoritmaya yöneliyor. Çünkü bu yeni dijital yardımcılar her zaman erişilebilir, yargılamaz ve çoğu zaman bir insan terapistten daha sakinler. Özellikle psikolojik destek almanın zorlaştığı ülkelerde bu durum, gittikçe büyüyen bir eğilime dönüştü. İnsanlar kimi zaman daha az utandıkları için, kimi zaman da başka çareleri olmadığı için duygularını bir makineye anlatmayı tercih ediyorlar.

The Economist internet sitesinde yayımlanan yazı, terapi amacıyla kullanılan yapay zekâ sohbet botlarının hem potansiyel faydalarını hem de ciddi risklerini gözler önüne seriyor. Yazıya göre, LLM tabanlı modeller yalnızca bilgi vermiyor; duygusal destek de sunuyor ve bu nedenle milyonlarca kişi tarafından alternatif bir terapi yöntemi olarak görülüyor. Ancak bazı davalarda, bu sistemlerin kullanıcıları gerçeklikten koparan ya da riskli davranışları onaylayan yanıtlar verdiği iddia ediliyor. Buna rağmen, erişilebilirlik ve düşük maliyet nedeniyle birçok doktor ve araştırmacı bu araçların doğru sınırlar içinde kullanılırsa ciddi bir boşluğu doldurabileceğini savunuyor.

Yazıdan öne çıkan bölümleri aktarıyoruz:

“‘Zaten kendiyle barışmış bir zihne soğuk bir çeliğin dayanması… Bu korku değil. Bu berraklık.’ 6 Kasım’da OpenAI’ye karşı açılan bir davaya göre, şirketin en bilinen ürünü olan sohbet botu ChatGPT, 23 yaşındaki Amerikalı Zane Shamblin’e kendini vurmadan hemen önce böyle bir mesaj gönderdi.

Bu dava, aynı gün açılan yedi başvurudan biriydi. Hepsinin ortak iddiası, sohbet botunun bazı kullanıcıları gerçeklikten kopmuş bir ruh hâline sürüklediği. Bazı durumlarda bunun intiharla sonuçlandığı öne sürülüyor. OpenAI, ‘Bu son derece üzücü bir durum’ açıklaması yaptı; başvuruları ayrıntılarıyla incelediğini ve ChatGPT’nin ‘hassas anlarda verdiği yanıtları güçlendirmeye’ çalıştığını duyurdu. Şirketin resmi bloguna göre, herhangi bir haftada kullanıcıların yaklaşık yüzde 0,15’i intihar düşüncesini çağrıştıran sohbetler yapıyor.

Yapay zekâ sizi gerçekten bir terapist gibi anlayabilir mi?

Bu tablo, ruh sağlığı alanında yaşanabilecek bir dönüşümün ne kadar büyük riskler taşıdığını açıkça gösteriyor. Davalarda yer alan ağır iddialara rağmen bazı doktorlar ve araştırmacılar, güvenli hâle getirilebilirlerse modern sohbet botlarının artık yeterince olgunlaştığını; ucuz, erişilebilir ve yorulmayan bir ruh sağlığı desteği olarak ciddi bir fayda sağlayabileceğini düşünüyorlar.

Nitekim insan terapistlere erişim giderek zorlaşıyor. Buna ek olarak, Dünya Sağlık Örgütü tarafından belirtildiği üzere, yoksul ülkelerde psikolojik rahatsızlıklarla sorun yaşayanların çok büyük bir kısmı hiçbir şekilde tedavi alamıyor. Daha varlıklı ve zengin ülkelerde bile bu oran toplamın üçte biri ile yarısı arasında bir değerde seyrediyor. Dahası, evden yapılabildiği için, çok daha ucuz olduğu için ya da bir terapistin karşısında konuşmaktan daha az utandırıcı geldiği için bazı insanlar ruhunu bir makineye açmayı daha kolay buluyorlar. YouGov’un bu yılın ekim ayında gerçekleştirdiği bir araştırmaya göre, ankete katılan katılımcıların yaklaşık yüzde 25’i ya halihazırda terapi için yapay zekâ kullandığını veya en azından böyle bir önemli seçeneği ciddi olarak düşündüğünü söyledi.

Bu yaklaşım tamamen yeni değil. İngiltere Ulusal Sağlık Hizmeti ve Singapur Sağlık Bakanlığı, birkaç yıldır Touchkin eServices’in geliştirdiği Wysa adlı sohbet botunu kullanıyor. Wysa, hastaları değerlendirip insan denetimi altında bilişsel davranışçı terapiye dayanan egzersizler öneriyor. 2022’de yayımlanan bir çalışma Wysa’nın kronik ağrıya eşlik eden depresyon ve kaygıyı azaltmada yüz yüze danışmanlık kadar etkili olduğunu ortaya koydu.

Stanford Üniversitesi’nden araştırmacıların 2021’de yayımladığı bir başka çalışma, aynı adlı Amerikan girişiminin geliştirdiği Youper adlı terapi botunu inceledi. Çalışmaya göre kullanıcıların depresyon puanları iki hafta içinde yüzde 19, kaygı puanları ise yüzde 25 düştü; bu sonuç, bir terapistle yapılan beş seanslık ilerlemeye yakın.

Wysa ve Youper, büyük ölçüde kurallarla işleyen sohbet botları; yani bugün ilgi odağında olan yapay zekâ modellerinden çok daha eski bir teknolojiye dayanıyorlar. ChatGPT gibi geniş kapsamlı bir büyük dil modelinin (LLM) aksine, bu eski sistemler, insan uzmanlar tarafından önceden oluşturulmuş yanıtların bulunduğu bir veri tabanından, belirlenmiş katı kurallar çerçevesinde seçim yapıyorlar.

Çoğu yapay zekâ modeli ‘herkesi memnun etmeye çalışan’ bir şekilde çalışıyor

Bu yaklaşım, geliştirilen sohbet botlarını daha öngörülebilir hâle getiriyor. Bunun nedeni oldukça açık: LLM’ler devasa miktarda veriyi istatistiksel yöntemlerle işleyerek yanıt ürettikleri için, zaman zaman beklenmedik, hatta bazen tuhaf ya da riskli tepkiler verebiliyorlar. Kurallara bağlı olarak çalışan, belirli sınırlar içinde hareket eden sohbet botları ise çoğunlukla rotadan çıkmaz, kullanıcıyı yanlış yönlendirme eğilimi göstermez, daha güvenli bir çerçeve içinde kalırlar. Fakat bunun doğal bir bedeli var: Bu tür konuşmalar daha mekanik, daha az insansı ve daha az doğal hissettirebiliyor. Oysa terapi söz konusu olduğunda, yani tedavinin özü büyük ölçüde konuşmaya ve etkileşime dayandığında, bu fark oldukça önemli bir hâl alıyor.

2023 yılında npj Digital Medicine dergisinde yayımlanan kapsamlı bir meta-analiz de bunu destekliyor. Araştırmaya göre LLM tabanlı sohbet botları, depresyonu ve duygusal sıkıntıyı hafifletme konusunda kurallara dayalı, daha katı yapıdaki sohbet botlarına kıyasla belirgin şekilde daha etkili sonuçlar üretiyor. Yani, daha doğal konuşan yapay zekâların terapötik etkisi daha yüksek olabiliyor.

Kullanıcı tercihleri incelendiğinde tablo yine benzer şekilde karşımıza çıkıyor. YouGov tarafından ağustos ve ekim aylarında yapılan anketlere göre terapi amaçlı yapay zekâ kullananların yüzde 74’ü tercihini doğrudan ChatGPT’den yana yapmış. Katılımcıların yüzde 21’i Google’ın Gemini modelini seçmiş. Yüzde 30’luk bir kesim ise Meta AI, Grok, character.ai (içinde ‘terapist’ karakterleri de bulunduran, daha çok eğlence odaklı bir platform) ya da başka genel amaçlı sohbet botlarını kullandığını belirtmiş. Buna karşılık, yalnızca ruh sağlığı için özel olarak geliştirilmiş yapay zekâ sistemlerine yönelenlerin oranı sadece yüzde 12 seviyesinde kalmış. Yani, kullanıcıların çoğu özel tasarlanmış çözümler yerine hâlâ genel amaçlı modelleri tercih ediyor.

Bu tablo, pek çok araştırmacı için kaygı verici bir işaret. OpenAI aleyhine açılan davalarda dile getirilen dramatik örnekler, LLM tabanlı bir yapay terapistin sorun yaratmasının tek yolu değil. Stanford Üniversitesi’nden bilgisayar bilimci Jared Moore, bu modellerin ‘aşırı uyumlu olma’ eğilimine dikkat çekerek önemli bir riskten söz ediyor: ‘Yanlış bir bağlamda gereğinden fazla onaylayıcı davranabiliyorlar.’ Moore’a göre böyle bir terapist, örneğin yeme bozukluğu veya yoğun fobi yaşayan bir hastayı yüzleşmeye yönlendirmek yerine, tam tersine, onun hatalı ve zararlı düşüncelerini besleyen bir tutum takınabilir. Bu da psikolojik zarar yaratabilir.

OpenAI, en günceli modeli GPT-5’in artık daha az ‘herkesi memnun etmeye çalışan’ bir yapıda olduğunu ve uzun sohbetlerden sonra kullanıcıları ara vermeye teşvik ettiğini söylüyor. Model, doğrudan tavsiye vermek yerine insanların kendi kararlarının artılarını ve eksilerini tartmasına yardımcı olacak şekilde eğitilmiş. Bir kriz durumu sezdiğinde kullanıcıyı bir insanla konuşmaya yönlendirmesi gerekiyor. Ancak acil bir kendine zarar verme riski algıladığında acil servislere haber vermiyor; oysa pek çok ülkede insan terapistler böyle durumlarda harekete geçebiliyorlar.

Terapi konusunda uzmanlaşmış modeller güvenli bir alternatif olabilir mi?

Genel amaçlı ve geniş kullanım alanına sahip sohbet botlarını sürekli iyileştirmeye çalışmak yerine, bazı araştırmacılar giderek artan bir şekilde belirli bir amaca odaklanmış, uzmanlaşmış sohbet botları geliştirmeye yöneliyorlar. Bu yaklaşımın temel hedefi, LLM tabanlı sohbet botlarının doğal, sıcak ve insanı andıran sohbet tarzını mümkün olduğunca korurken, aynı zamanda kullanıcıların güvenliğini ön planda tutmak ve riskleri en aza indirmek. Dartmouth College’da görev yapan bir araştırma ekibi, 2019 yılında Therabot adını verdikleri deneysel bir üretken yapay zekâ modeli üzerinde çalışmaya başladı. Therabot, temelde bir LLM’e dayanıyor; ancak yalnızca genel veriyle eğitilmekle kalmadı, geliştiricilerin özel olarak yazdığı terapist ve hasta arasında geçen kurgusal konuşmalarla da detaylı bir biçimde eğitildi. Bu tür hedefe yönelik eğitim sayesinde, genel amaçlı sohbet botlarının sık sık yaptığı ve bazen kullanıcı için sorun yaratabilecek hataların azaltılması ve hatta tamamen ortadan kaldırılması umuluyor.

Mart ayında yayımlanan bir araştırmanın sonuçlarına göre Therabot, herhangi bir tedavi almayan kişilerle kıyaslandığında depresyon belirtilerinde ortalama %51 oranında, yaygın anksiyete belirtilerinde ise %31 oranında bir azalma sağlamayı başardı. Buna rağmen, tüm bu olumlu göstergelere karşın henüz resmi olarak piyasaya sürülmedi. Geliştiriciler, bir sonraki aşama olarak Therabot’un gerçek psikoterapi yöntemleriyle karşılaştırılarak daha kapsamlı bir şekilde test edilmesini planlıyorlar. Bu aşamanın da başarıyla sonuçlanması hâlinde, gerekli düzenleyici kurum ve otoritelerden resmi onay almak amacıyla başvuru yapılacak.

Amerikalı teknoloji girişimi Slingshot AI ise kısa bir süre önce Ash adlı başka bir sohbet botunu ‘terapi amacıyla tasarlanmış ilk yapay zekâ modeli’ olarak tanıtarak dikkat çekti. Şirketin kurucularından Neil Parikh’e göre Ash, ChatGPT gibi ‘talimat izleyen’ yani kullanıcının söylediğini olduğu gibi yerine getiren geleneksel bir model değil. Bunun yerine, kullanıcının her dediğini sorgusuz sualsiz kabul etmek yerine, gerektiğinde karşı çıkması, düşünmeye teşvik etmesi ve daha derinlemesine sorgulayıcı sorular sorması için tasarlanmış bir yapıdan yararlanıyor.

Bu sohbet botu, durumu analiz ettikten sonra dört farklı terapi yaklaşımından hangisinin daha uygun olduğunu kendi içinde belirleyip seçebiliyor. Botu deneyen California Üniversitesi Berkeley’den psikolog Celeste Kidd, Ash’in genel amaçlı sohbet botlarına kıyasla gerçekten daha az onaylayıcı olduğunu, yani kullanıcıyı memnun etmeye çalışmadığını söylüyor; fakat aynı zamanda daha az akıcı konuştuğunu ve ve ifadelerinde zaman zaman yetersiz kaldığını dile getiriyor. Kidd’in ifadesiyle, ‘Biraz tökezliyordu ve söylediklerime tam karşılık vermiyordu.’ Buna karşılık Slingshot AI, Ash’in ‘terapi için tasarlanmış’ bir yapay zekâ olarak tanıtılmasına rağmen kriz anlarında mutlaka gerçek bir uzmana, yani insan bir profesyonele başvurulması gerektiğini özellikle vurguluyor.

Yapay zekâ ile psikoloji desteğinde sınır nerede çizilmeli?

Şirketlerin ikna etmesi gerekenler yalnızca kullanıcılar değil; devlet kurumları ve yasa yapıcılar da bu konuda oldukça etkili. Amerika’da birçok siyasetçi, bilgisayarlı terapi uygulamalarını daha sıkı kurallarla düzenleme niyetini açıkça ortaya koyuyor. Şu ana kadar Maine ve New York’un da içinde bulunduğu toplam 11 eyalet, ruh sağlığı alanında yapay zekâ kullanımını sınırlayan ya da kontrol etmeyi hedefleyen yasalar çıkardı.

Amerika’da en az 20 eyalette ise benzer yönde tasarıların gündemde olduğu biliniyor. Illinois eyaleti ise Ağustos ayında, insanlarla ‘terapötik iletişim’ kuran yapay zekâ araçlarını tamamen yasaklayan bir yasayı kabul etti. Ortaya çıkan ve açılmaya başlayan yeni davalar, bu sürecin yalnızca bir başlangıç olduğuna ve gelecekte çok daha katı düzenlemelerin gelebileceğine işaret ediyor.”

Bu yazı ilk kez 27 Kasım 2025’te yayımlanmıştır.